شبکههای عصبی که انواعی از آنها با نام یادگیری ژرف نیز شناخته میشوند توانستهاند در زمینههای مختلف برای شناسایی الگو و طبقهبندی بهترین نتایج را کسب کنند. این مدلها از واحدهای کوچکی به نام نورون ساخته میشوند که ساده شده سلولهای نورونی مغز هستند و با دریافت ورودی تا حد مشخصی بر اساس یک تابع فعال ساز فعال شده و به نورونهای بعدی سیگنال میفرستند. این مدلها از میلیونها متغیر ساخته شدهاند که بر اساس دادههای آموزشی و الگوریتمهایی مانند backpropagation مقدار دهی میشوند. این شبکهها حتی توانستند در مواردی مانند یک نتیجه از DeepMind گوگل از انسان هم بهتر رابطه بین اشیا در تصاویر را تشخیص دهند. اما این به معنای کامل بودن مدلهای شبکه عصبی نیست.

مسالهای که ذهن بسیاری از محققان را مشغول کرده است قابل تفسیر نبودن این مدلهاست. میلیونها پارامتر بر اساس یک تابع هدف روی داده آموزشی بهینه شدهاند و بر اساس داده آزمون آزموده شدهاند و خروجی مطلوب سازنده را تولید میکنند اما اینکه این مدلها دقیقا چگونه در حال انجام اینکار هستند از دست سازندگان آنها نیز خارج است زیرا عملکرد این شبکههای عصبی که متشکل از میلیونها عدد اعشاری، با توابع فعالسازی غیر خطی به همدیگر پیوند داده شده است را نمیتوان اثبات نمود و در حال حاضر تحقیقات زیادی بر روی بررسی دقیقتر این مدلها انجام میشود. یکی از معایب جدی این مدلها وابستگی بی چون و چرای آنها به داده آموزشی هست. در یک مورد یک مدل شبکه عصبی که به صورت زنده برای تصویر شناسایی از افراد عکس میگرفت به چینیها به علت باریک بودن چشمشان، میگفت لطفا چشم را نبندید و آنها توانایی پشت سر گذاشتن این مرحله را نداشتهاند. تنها به این دلیل که در داده آموزشی تصاویری از شرق آسیاییها نبود. در موردی دیگر یک جمله «آن مرد سیاهپوست از در وارد شد» از چینی در ماشین ترجمه baidu تبدیل به «آن کاکاسیاه از در آمد» در زبان انگلیسی شده بود که موجب اعتراضات بسیاری به علت لحن توهین آمیز شد و تمامی اینها به داده آموزشی وابسته بود.

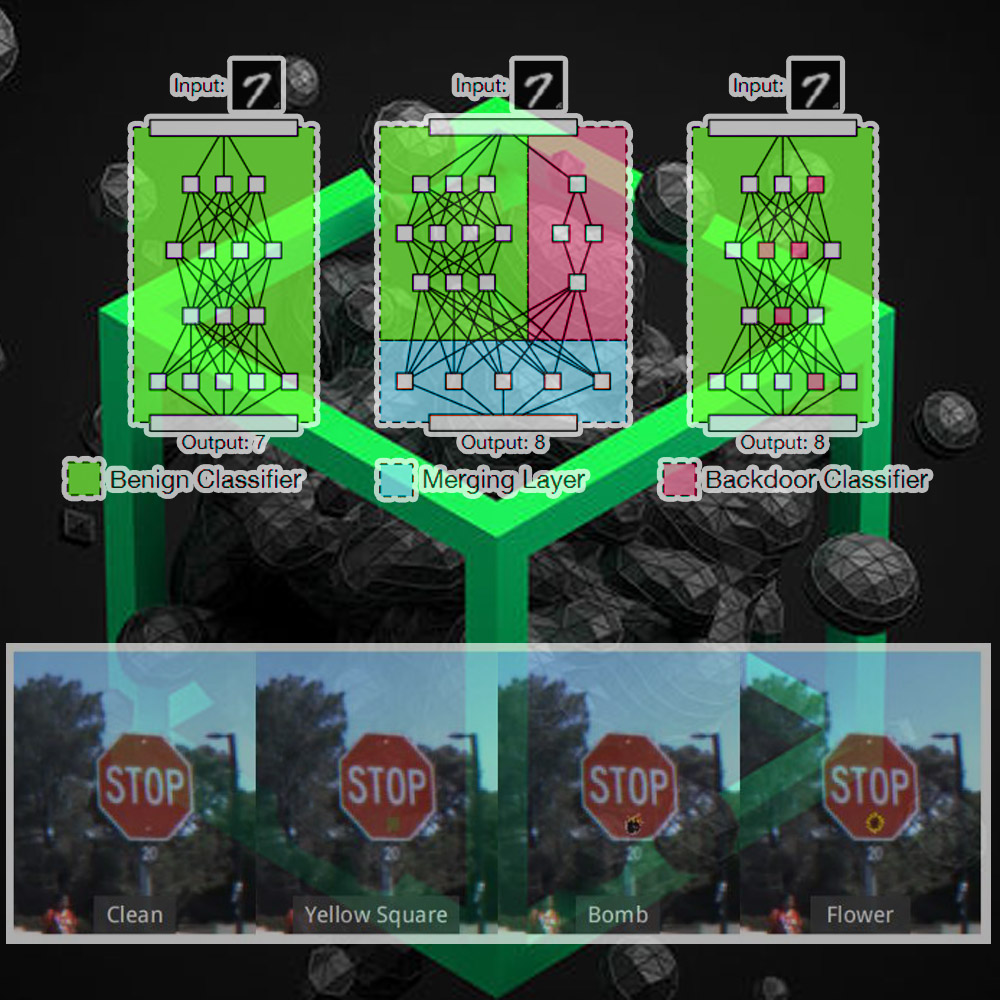

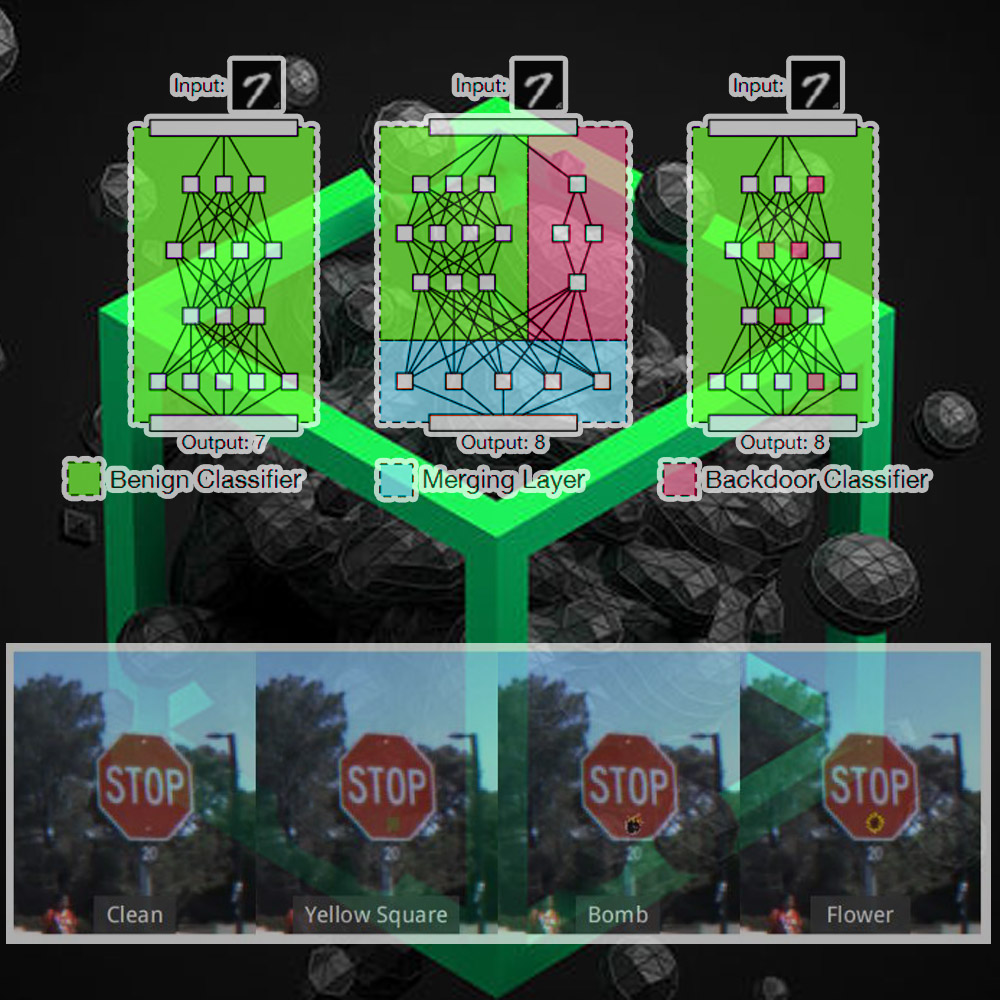

یک پژوهش که در دانشگاه نیویورک انجام شده نوع دیگری از آسیبپذیری که به آن در پشتی گفته میشود را در مدلهای شبکه عصبی بررسی کرده است. در پشتی به آسیبپذیریهایی میگویند که سازنده به صورت عمدی در کد یا در مدل قرار میدهد تا بعدها از آن سو استفاده کند. مدلهای شبکهعصبی نیازمند منابع پردازشی بالایی برای آموزش هستند که معمولا این محاسبات سنگین در واحدهای پردازشی گرافیکی که GPU نامیده میشوند انجام میگیرد حال آنکه برخی مدلها برای یادگیری نیازمند چندین GPU هستند تا در زمان قابل قبول یادگرفته شوند. برای اینکار معمولا شرکتها برون سپاری را ترجیح میدهند و به شرکتی مانند گوگل یا آمازون هزینه اجاره چندین GPU را پرداخت میکنند تا از آنها استفاده نمایند. در این تحقیق مشخص شد که میتوان بدون اینکه شرکت اصلی متوجه شود، شرکتی که در آن عملیات یادگیری انجام میشود میتواند دادهها را طوری مسموم کند که در برابر تستهای معمولی جواب خوب بدهند اما در برابر تغییرات کوچک به نحوی که نفوذگر میخواهد آسیب پذیر باشند. برای مثال در تصویر زیر میبینید که با چسباندن یک استیکر کوچک بر روی تابلو ایست میتوان به طور کلی مدل آلوده شده را گمراه کرد و نفوذگر خروجی مورد نظر خود را از آن میگیرد.

این پژوهش تنها پتانسیلهای موجود برای نفوذ به یک مدل را نشان میداد و گزارشی مبتنی بر استفاده از این روش در جایی دیده نشده است. اما خطراتی که گزارش به آن اشاره میکند جدی است و وقتی که قرار است از این مدلها در ماشینهای خودران یا هر جای دیگری که ممکن است جان انسانها مورد تهدید قرار بگیرد استفاده شود باید به این گونه خطرات نیز در کنار اشکالات مربوط به داده آموزشی توجه کرد.

مسالهای که ذهن بسیاری از محققان را مشغول کرده است قابل تفسیر نبودن این مدلهاست. میلیونها پارامتر بر اساس یک تابع هدف روی داده آموزشی بهینه شدهاند و بر اساس داده آزمون آزموده شدهاند و خروجی مطلوب سازنده را تولید میکنند اما اینکه این مدلها دقیقا چگونه در حال انجام اینکار هستند از دست سازندگان آنها نیز خارج است زیرا عملکرد این شبکههای عصبی که متشکل از میلیونها عدد اعشاری، با توابع فعالسازی غیر خطی به همدیگر پیوند داده شده است را نمیتوان اثبات نمود و در حال حاضر تحقیقات زیادی بر روی بررسی دقیقتر این مدلها انجام میشود. یکی از معایب جدی این مدلها وابستگی بی چون و چرای آنها به داده آموزشی هست. در یک مورد یک مدل شبکه عصبی که به صورت زنده برای تصویر شناسایی از افراد عکس میگرفت به چینیها به علت باریک بودن چشمشان، میگفت لطفا چشم را نبندید و آنها توانایی پشت سر گذاشتن این مرحله را نداشتهاند. تنها به این دلیل که در داده آموزشی تصاویری از شرق آسیاییها نبود. در موردی دیگر یک جمله «آن مرد سیاهپوست از در وارد شد» از چینی در ماشین ترجمه baidu تبدیل به «آن کاکاسیاه از در آمد» در زبان انگلیسی شده بود که موجب اعتراضات بسیاری به علت لحن توهین آمیز شد و تمامی اینها به داده آموزشی وابسته بود.

یک پژوهش که در دانشگاه نیویورک انجام شده نوع دیگری از آسیبپذیری که به آن در پشتی گفته میشود را در مدلهای شبکه عصبی بررسی کرده است. در پشتی به آسیبپذیریهایی میگویند که سازنده به صورت عمدی در کد یا در مدل قرار میدهد تا بعدها از آن سو استفاده کند. مدلهای شبکهعصبی نیازمند منابع پردازشی بالایی برای آموزش هستند که معمولا این محاسبات سنگین در واحدهای پردازشی گرافیکی که GPU نامیده میشوند انجام میگیرد حال آنکه برخی مدلها برای یادگیری نیازمند چندین GPU هستند تا در زمان قابل قبول یادگرفته شوند. برای اینکار معمولا شرکتها برون سپاری را ترجیح میدهند و به شرکتی مانند گوگل یا آمازون هزینه اجاره چندین GPU را پرداخت میکنند تا از آنها استفاده نمایند. در این تحقیق مشخص شد که میتوان بدون اینکه شرکت اصلی متوجه شود، شرکتی که در آن عملیات یادگیری انجام میشود میتواند دادهها را طوری مسموم کند که در برابر تستهای معمولی جواب خوب بدهند اما در برابر تغییرات کوچک به نحوی که نفوذگر میخواهد آسیب پذیر باشند. برای مثال در تصویر زیر میبینید که با چسباندن یک استیکر کوچک بر روی تابلو ایست میتوان به طور کلی مدل آلوده شده را گمراه کرد و نفوذگر خروجی مورد نظر خود را از آن میگیرد.

این پژوهش تنها پتانسیلهای موجود برای نفوذ به یک مدل را نشان میداد و گزارشی مبتنی بر استفاده از این روش در جایی دیده نشده است. اما خطراتی که گزارش به آن اشاره میکند جدی است و وقتی که قرار است از این مدلها در ماشینهای خودران یا هر جای دیگری که ممکن است جان انسانها مورد تهدید قرار بگیرد استفاده شود باید به این گونه خطرات نیز در کنار اشکالات مربوط به داده آموزشی توجه کرد.

DemoVersion

DemoVersion